Warum Grafikkarten (GPUs) Unverzichtbar für die Effizienz von Lokaler Künstlicher Intelligenz (KI) sind

Grafikkarten wurden ursprünglich für die Verbesserung von Grafikeffekten und 3D-Spielen entwickelt – soweit so bekannt für Gamer. Doch mittlerweile haben sie sich zusätzlich als unverzichtbar für lokale künstliche Intelligenz (KI) etabliert. Aber warum sind diese Pixelbeschleuniger so bedeutend für die Welt der KI? Wir gehen dieser Frage auf den Grund.

Was ist eine Grafikkarte (GPU)?

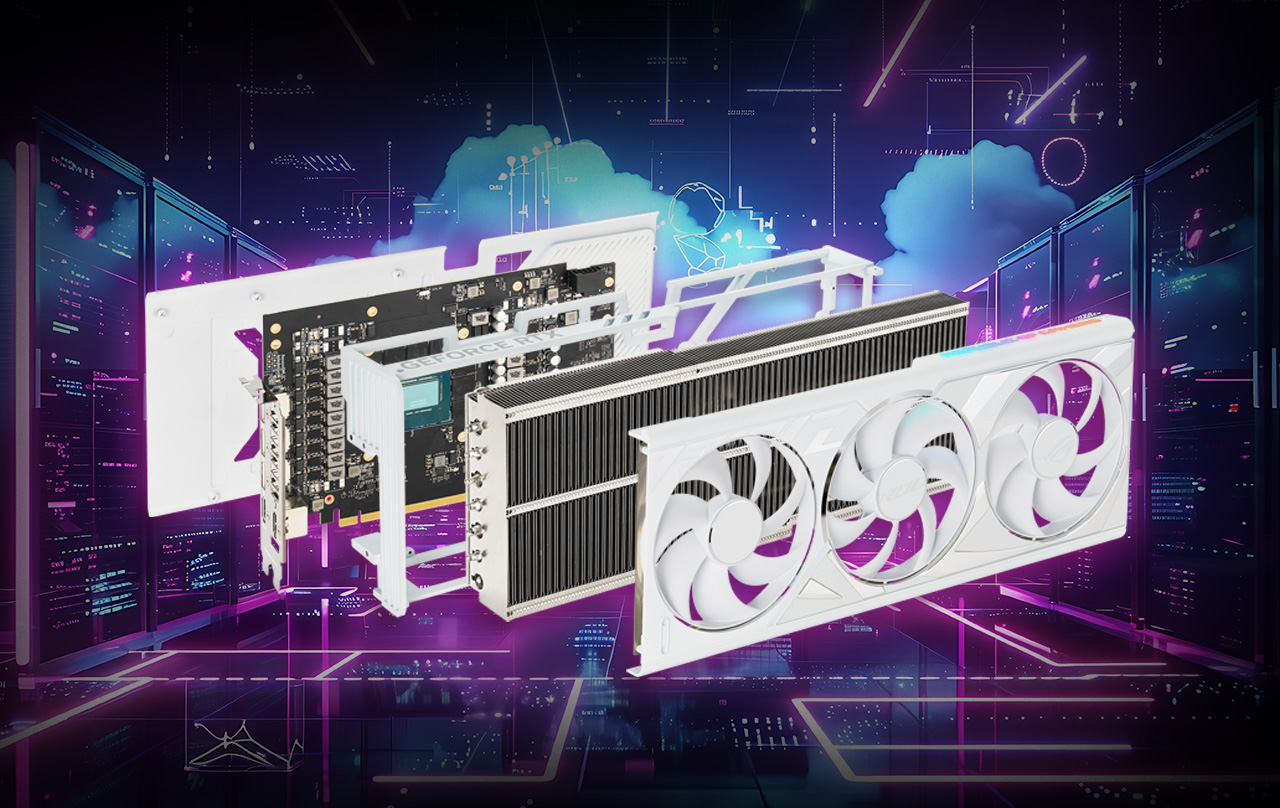

Eine Grafikkarte, auch bekannt als GPU (Graphics Processing Unit), ist ein leistungsstarkes Subsystem, das speziell dafür entwickelt wurde, komplexe geometrische Berechnungen in Echtzeit zu verarbeiten. Dies ist entscheidend, um realistische 2D- und 3D-Spielewelten zu rendern, in der wir uns verlieren und stundenlang umherwandern. Die GPU kann deswegen viele einfache Berechnungen gleichzeitig anstellen und die Ergebnisse in einer sogenannten Pipeline an die jeweils nächste Recheneinheit weiterreichen – praktisch der schwarze Gürtel des Multitaskings. Um noch mehr Performance aus dem System zu holen, verfügen die Grafikkarten heute auch über einen sehr großen und sehr schnellen autarken Arbeitsspeicher. Diese Architektur ist ideal für die Verarbeitung von KI-Berechnungen, da sie große Datenmengen effizient bewältigen kann.

Wie nutzt künstliche Intelligenz die GPU?

Künstliche Intelligenz funktioniert durch die Simulation eines Netzwerks von Neuronen. Ein digitales Neuron erhält Eingabewerte und gibt Ergebnisse an andere Neuronen weiter. Ein neuronales Netzwerk besteht aus Millionen solcher Neuronen, die miteinander verbunden sind und sozusagen im „Koop spielen“. Diese Netzwerke werden auf der GPU abgebildet, da die GPU in der Lage ist, diese komplexen Berechnungen parallel und schnell durchzuführen.

Während der Trainingsphase wird das Netzwerk mit Daten konfrontiert, um seine Leistung zu verbessern und präzisere Ergebnisse zu liefern. In der Anwendungsphase wird das trainierte Modell auf der GPU eingesetzt, um reale Probleme zu lösen. Dank der Vielzahl von Kernen und dem schnellen Zugriff auf den Arbeitsspeicher kann die GPU diese Aufgaben wesentlich schneller erledigen als eine CPU.

Warum ist Geschwindigkeit entscheidend?

Wie du dir vorstellen kannst, laufen Berechnungen und Anfragen auf kleineren Grafikkarten naturgemäß langsamer als auf größeren und leistungsstärkeren ab. Läuft der Chatbot auf der CPU, dauert es noch länger. Stelle dir eine Unterhaltung mit einem Gesprächspartner vor: Wäre es nicht nervend, wenn der Konversationspartner immer zwei Minuten Bedenkpause braucht für jede deiner Fragen? Genauso ist es auch mit GPT: Nach 10 Sekunden sollten sich die Antworten bilden. Nur so ergibt sich ein flüssiger Workflow.

Ist meine Grafikkarte leistungsfähig genug?

Die Komplexität von KI-Modellen nimmt jedes Jahr etwa um das Zehnfache zu. Das neueste, hochmoderne Large Language Model (LLM), GPT-4, umfasst mehr als eine Billion Parameter (was eine 1 mit 12 Nullen ergibt). Die GPU-Systeme müssen sich dieser Herausforderung stellen. Moderne GPUs, die NVLink und Quantum InfiniBand-Netzwerke nutzen, bieten die nötige Leistung für diese Herausforderungen und skalieren auf Supercomputing-Niveau.

Speziallösungen auf dem Vormarsch - auch für die lokale KI?

Neben GPUs entwickeln einige Anbieter spezielle Prozessorenkonzepte für KI-Anwendungen, insbesondere im Bereich autonomes Fahren und Rechenzentren. Diese spezialisierten Lösungen sind für konkrete Anwendungen optimiert. Für die allgemeine lokale Nutzung bleibt die GPU jedoch die vielseitigste und effektivste Lösung und damit nach wie vor deine Lieblingskomponente.

Lokale KI in aktuellen Anwendungen - dort geht die Reise hin

Grafikkarten spielen eine zentrale Rolle bei der Beschleunigung lokaler KI-Systeme. Viele Softwarehersteller integrieren bereits KI-Assistenten in ihre Produkte, von Foto- und Animationssoftware bis hin zu Video-Plattformen. Auch Microsoft plant, KI in Windows 12 fest zu integrieren. Dieser Trend wird sich weiter fortsetzen, und KI wird zunehmend in mehr Systemen Einzug halten, um dir im Alltag nützlich zur Seite zu stehen.

Fazit

Generative KI wird sowohl im privaten als auch im geschäftlichen Bereich immer wichtiger. Moderne ASUS-Grafikkarten sind bereits für die anspruchsvollen KI-Anforderungen gerüstet und bieten leistungsstarke, zuverlässige Lösungen für die kommenden Herausforderungen.

Dank fortschrittlicher Kühlungstechnologien und spezieller Tensor-Kerne bieten ASUS-Grafikkarten optimale Leistung für KI-Anwendungen, ohne dabei unnötige und störende Lautstärke zu produzieren. Diese Tensor-Kerne beschleunigen die Verarbeitung von neuronalen Netzwerken und Deep Learning erheblich, wodurch die Effizienz und Geschwindigkeit der KI-Berechnungen weiter optimiert werden. Die hochwertige AutoExtreme-Fertigung und die zuverlässige Stromversorgung sorgen für einen stabilen, ausfallsicheren Betrieb, der bereits jetzt für maschinelles Lernen und KI-Algorithmen bestens geeignet ist. Grafikkarten erhalten also in Zukunft noch einen wichtigeren Stellenwert in deinem PC als bereits jetzt schon und werden dich bei kommenden Entwicklungen begleiten.

Autor

Popular Post

ROG Xbox Ally und Ally X: Leistungsstarke Handhelds für Gaming-Enthusiasten

ROG Azoth X: Gaming-Tastatur im 75%-Formfaktor mit galaktischem Design

GPU Tweak's Power Detector+ überwacht die Energiewerte der ROG Astral-Grafikkarten

Die besten Gaming-Monitore für 2025: ROG Swift und Strix XG-Serie im Vergleich – von OLED bis IPS

ASUS GPU TWEAK III: Das ultimative Grafikkarten-Overclocking-Tool

Neueste Artikel

GPU Tweak's Power Detector+ überwacht die Energiewerte der ROG Astral-Grafikkarten

Mit der neuen Power Detector+-Funktion auf unseren ROG Astral-Grafikkarten weißt du immer genau, was mit deiner Karte los ist.

ASUS GPU TWEAK III: Das ultimative Grafikkarten-Overclocking-Tool

Maximiere die Leistung deiner GPU mit GPU Tweak III, der erstklassigen Übertaktungssoftware von ASUS - jetzt mit noch mehr exklusiven Funktionen.

ROG Astral vs Strix vs TUF vs Prime: Welche Grafikkarte von ASUS ist die richtige für dich?

Entdecke die Vielfalt der ASUS und ROG Grafikkarten! Von High-End ROG Astral bis zum preiswerten ASUS Prime – finde die perfekte GPU für dein Gaming-Setup und Budget. Jetzt vergleichen

Warum Grafikkarten (GPUs) Unverzichtbar für die Effizienz von Lokaler Künstlicher Intelligenz (KI) sind

Grafikkarten von ASUS ROG sind mehr als nur die perfekten Pixelbeschleuniger. Sie sind heutzutage das Fundament von lokaler künstlichen Intelligenz (KI) und beschleunigen deren Aufgaben erheblich.

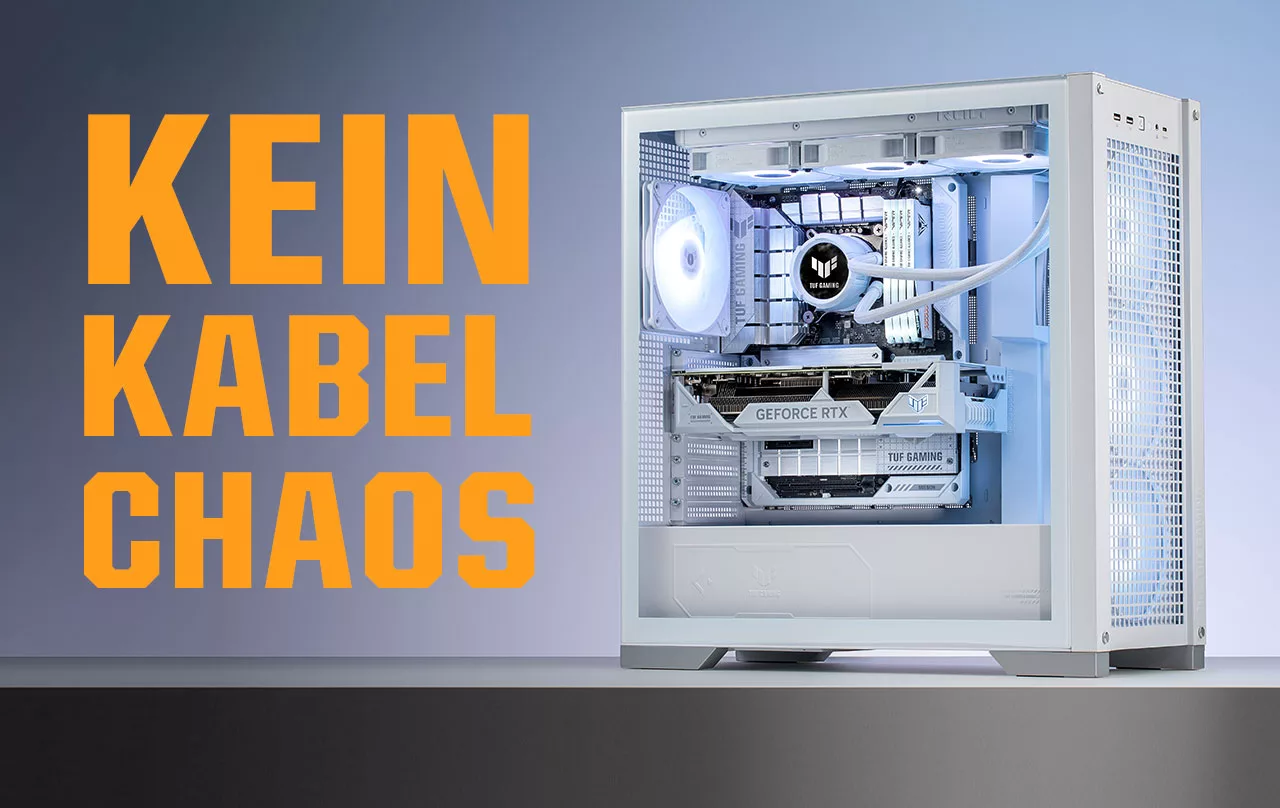

ASUS BTF Hidden Connector: Für die schönsten Gaming-Rigs und cleansten Gaming-PCs aller Zeiten

Das Motto eines ASUS BTF-Builds ist kurz und bündig: Versteck die Kabel und weg mit dem Chaos. Da die Anschlüsse und Header auf der Rückseite des Mainboards untergebracht sind, können alle Kabel versteckt werden und eine revolutionäre Optik mit dem besten Airflow sind möglich.

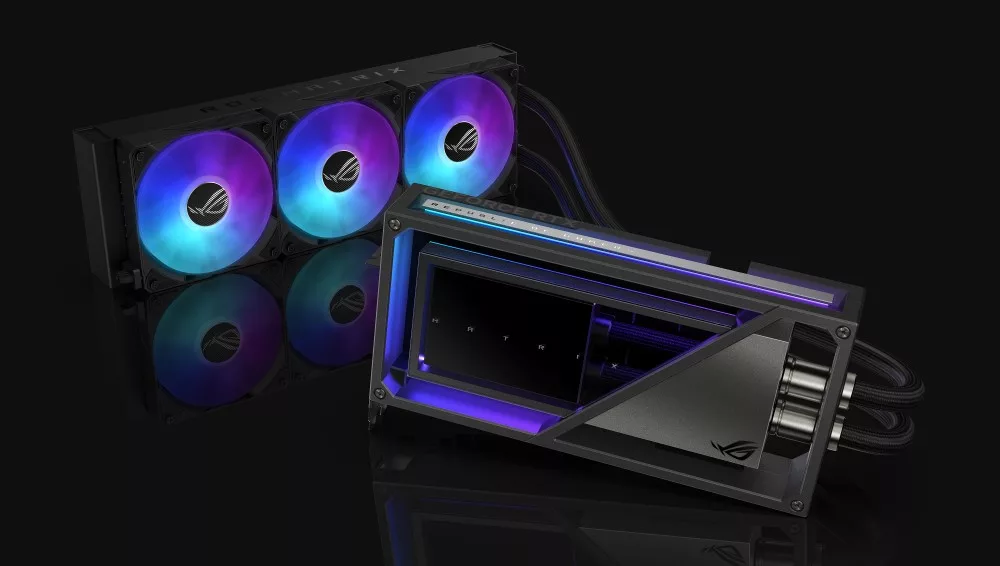

Eine Ikone kehrt zurück: Die ROG Matrix GeForce RTX 4090

Die ROG Matrix GeForce RTX 4090 hat den höchsten Boost-Takt aller RTX 4090 der Welt und kühlt als erste ROG-Karte alle Komponenten mit Flüssigmetall-Wärmeleitpaste.